Toda aplicação de Deep Learning é Machine Learning, mas nem toda aplicação de Machine Learning é Deep Learning

Inteligência Artificial (IA), Machine Learning e Deep Learning são as palavras do século. Cada vez mais presentes em nosso dia a dia, esses conceitos são frequentemente utilizados como sinônimos, mesmo possuindo significados diferentes.

Os avanços tecnológicos e recentes lançamentos, como o ChatGPT, têm os colocado ainda mais sob os holofotes, gerando grande interesse sobre o tema. Assim, o que antes era um assunto nichado, ganhou popularidade devido ao seu enorme poder transformador em todos os segmentos das nossas vidas.

Além disso, a utilização estratégica da IA é essencial para garantir o futuro dos negócios, proporcionando alta eficiência, produtividade e rentabilidade. Portanto, conhecer mais a fundo sobre essa questão e o que está relacionado a ela é fundamental.

Nesse sentido, uma das principais dúvidas que surgem é a diferença entre Machine Learning e Deep Learning, dois pilares da Inteligência Artificial. Solucionar essa questão é o foco deste artigo. Para contextualizar, vamos explicar o significado da Inteligência Artificial e a divisão dela em duas grandes categorias: a IA fraca/limitada e a forte.

O que se entende por Inteligência Artificial?

Poucos conceitos são tão mal compreendidos quanto a Inteligência Artificial. Pesquisas mostram que mesmo os principais executivos carecem de conhecimento sobre IA e que muitas pessoas comuns a confundem com robôs superpoderosos ou dispositivos hiperinteligentes. A falta de clareza sobre o termo abre espaço para más concepções.

Parte do problema é a falta de consenso sobre uma única definição. O britânico Alan Turing, considerado o pai da computação, especulou, em 1950, que “máquinas pensantes” poderiam raciocinar no nível de um ser humano. O tão conhecido “Teste de Turing” especifica que os computadores precisam desvendar enigmas, assim como os humanos, para serem considerados pensantes de maneira autônoma.

Alguns anos mais tarde, o americano John McCarthy utilizou o termo para representar máquinas que podem pensar de forma autônoma. Ele descreveu a Inteligência Artificial da seguinte forma: “conseguir que um computador faça coisas que, quando feitas por pessoas, envolvem inteligência”.

Assim, desde a década de 50, os cientistas discutem o que constitui o “pensamento” e a “inteligência”, e o que significa ser “totalmente autônomo” quanto se trata de hardwares e softwares.

Hoje, a IA é geralmente associada a “máquinas que respondem a estímulos consistentes com as respostas tradicionais dos humanos, dada a nossa capacidade de contemplação, julgamento e intenção”. Esses sistemas de software “tomam decisões que normalmente exigem um nível humano de especialização” e constituem a sua essência: intencionalidade, inteligência e adaptabilidade.

Resumindo: o que é Inteligência Artificial?

Podemos dizer, dessa forma, que a Inteligência Artificial é a habilidade das máquinas funcionarem como o cérebro humano e serem tão inteligentes como nós. É uma área da Ciência da Computação que utiliza computadores e grandes bases de dados para entender e simular o nosso raciocínio. O propósito é nos ajudar a resolver problemas, antecipando-os ou lidando com eles à medida que surgem.

Em outras palavras, trata-se do conjunto de técnicas voltadas a criar e treinar softwares capazes de aprender, raciocinar e tomar decisões, como os seres humanos. O termo também é muito utilizado para se referir às próprias aplicações que realizam tarefas complexas, que antes exigiam a intervenção e a inteligência de pessoas.

Algoritmos de IA são diferentes de máquinas passivas, apenas capazes de respostas mecânicas ou predeterminadas. Usando sensores, dados digitais ou entradas remotas, eles combinam informações de várias fontes diferentes, analisam o material instantaneamente e agem com base nos insights derivados desses dados. Por fim, chegam a conclusões fundamentadas em sua análise instantânea.

Semelhante ao cérebro humano, os sistemas de IA desenvolvem a capacidade de racionalizar e executar ações que tenham a melhor chance de atingir um objetivo específico.

Os benefícios, portanto, vão além da automação mecânica, englobando processos cognitivos, que geram uma capacidade de aprendizado. Dessa forma, um sistema de Inteligência Artificial consegue realizar atividades não apenas repetitivas, numerosas e manuais, como também as que demandam análise e tomada de decisão.

Evolução exponencial da IA

Devido aos avanços e melhorias profundas em sistemas de armazenamento, velocidades de processamento e técnicas analíticas, os algoritmos de IA são capazes de uma enorme sofisticação em análise e processos de escolha. Estudos indicam que a escala de performance da Inteligência Artificial está dobrando a cada 6 meses, superando, e muito, a Lei de Moore.

Essa é uma teoria que ficou comum no mundo da computação, sendo utilizada como referência e sinônimo de rápidos avanços. Seu nome remete ao cofundador da empresa Intel, Gordon Moore, que previu, em 1965, que o número de transistores em um microchip dobraria em intervalos regulares no futuro previsível, mais especificamente a cada 18 meses. Assim, o poder de processamento de dados dos computadores aumentaria exponencialmente.

Considerada uma das tecnologias mais promissoras nos dias atuais, a IA está em rápida ascensão. Suas aplicações têm crescido dia após dia e suas tecnologias têm sido implementadas como estratégia em todas as organizações e setores, globalmente.

É provável que a Inteligência Artificial contribua em cerca de US$ 16 trilhões para toda a economia mundial até 2030. De fato, ela já está alterando a forma como vivemos, trabalhamos, geramos valor e interagimos com o mundo ao nosso redor.

Tipos de IA: fraca e forte

Há duas grandes categorias de Inteligência Artificial conhecidas como “IA fraca” e “IA forte”.

IA fraca

A primeira, também chamada de Inteligência Artificial Limitada (ANI, do inglês Artificial Narrow Intelligence) ou IA especializada, é treinada para realizar tarefas específicas. Presente em nosso dia a dia em todas as aplicações de IA disponíveis, apesar do nome, ela não é nada fraca, pois permite aplicações bastante robustas. Afinal, ela já transformou praticamente todas as indústrias.

O seu foco específico permitiu muitos avanços tecnológicos em pouco tempo, nos últimos anos. Além disso, essa IA está estabelecendo uma base para o potencial da tecnologia, com o propósito de não apenas imitar e igualar a inteligência humana, mas superá-la em muito. Exemplos de IA fraca são assistentes virtuais, como a Alexa, da Amazon, os chatbots, os filtros de spam de e-mails, o Google Maps e os carros autônomos.

IA forte

Já a IA forte está no plano da teoria e é relacionada à criação de máquinas que têm autoconsciência e podem pensar, não somente simular raciocínios. Diferentemente da IA fraca, a IA forte não depende da interferência humana para definir os parâmetros de seus algoritmos de aprendizado e para oferecer dados de treinamento relevantes. Além disso, ela pode desempenhar diversas funções, eventualmente ensinando a si própria a resolver novos problemas.

Ela se refere à Inteligência Artificial Geral (AGI, do inglês Artificial General Intelligence) e à Superinteligência (ASI, do inglês Artificial Super Intelligence). A AGI, ou IA geral, possui inteligência equivalente à humana, com autoconsciência, capacidade de resolver problemas, aprender e planejar para o futuro. Em contrapartida, a IA superinteligente ultrapassa a inteligência e a capacidade do cérebro humano.

Machine Learning x Deep Learning

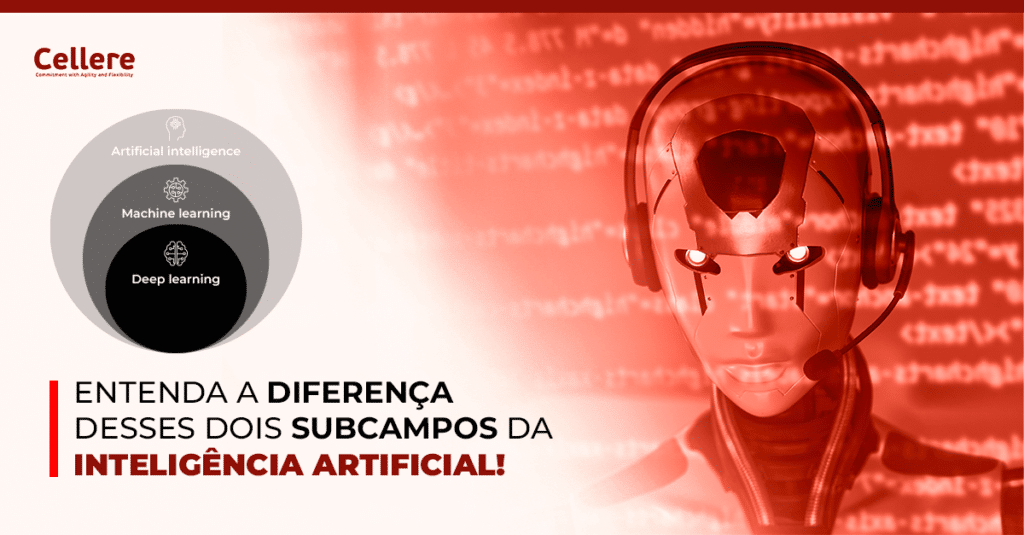

Ambos os termos são subcampos da Inteligência Artificial, no entanto Deep Learning (Aprendizado Profundo, em português) é uma forma evoluída de Machine Learning (Aprendizado de Máquina, em português). Portanto, eles não podem ser utilizados como sinônimos. A diferença fundamental está na maneira como cada algoritmo aprende.

Enquanto o algoritmo de Machine Learning é mais dependente da intervenção humana para aprender, o de Deep Learning é capaz de escalar a aprendizagem. Isso é possível automatizando a extração de recursos do processo, eliminando parte da intervenção humana necessária, permitindo o uso de maiores conjuntos de dados.

Saiba mais sobre cada um desses conceitos a seguir!

O que é Machine Learning?

Como o próprio nome diz, Machine Learning se refere ao aprendizado de máquinas por meio de dados. Trata-se de uma aplicação de Inteligência Artificial que inclui algoritmos que analisam dados, aprendem com eles e aplicam o conhecimento adquirido para tomar decisões informadas.

É uma área que associa a Ciência da Computação com a Estatística, na qual os algoritmos são usados para executar uma tarefa específica sem serem explicitamente programados. Em vez disso, eles reconhecem padrões nos dados e fazem previsões quando novos dados chegam.

Machine Learning envolve muita matemática e codificação complexas que, no final das contas, têm a mesma função mecânica de uma lanterna, carro ou tela de computador. Quando dizemos que algo é capaz de “aprendizado de máquina”, significa que ele executa uma função com os dados fornecidos e melhora progressivamente com o tempo. É como se você tivesse uma lanterna que acendesse sempre que dissesse: “está escuro”.

Em geral, o processo de aprendizado desses algoritmos pode ser supervisionado ou não, dependendo dos recursos usados para alimentar os algoritmos.

Um algoritmo tradicional de Machine Learning pode ser tão simples quanto uma função de regressão linear. Ele atua por meio do modelo de Mínimos Quadrados Ordinários (MQO), utilizado para calcular os coeficientes de uma regressão linear de tal forma que os erros, ou melhor, a soma dos quadrados dos erros seja a menor possível.

Ou seja, a força motriz por trás do Aprendizado de Máquina são as estatísticas comuns. Com isso, o algoritmo aprende a fazer uma previsão sem ser explicitamente programado, apenas com base em padrões e inferências.

Resumindo:

- Machine Learning está na interseção da Ciência da Computação e da Estatística, por meio da qual os computadores recebem a capacidade de aprender sem serem explicitamente programados.

- Existem duas grandes categorias de problemas de Machine Learning: aprendizado supervisionado e não supervisionado.

- Um algoritmo de Machine Learning pode ser algo tão simples quanto uma regressão linear.

Agora, vamos analisar como o termo Deep Learning se relaciona com tudo isso.

Saiba mais assistindo ao vídeo:

O que é Deep Learning?

Os algoritmos de Deep Learning podem ser considerados uma evolução sofisticada e matematicamente complexa dos algoritmos de Machine Learning. O campo tem recebido muita atenção ultimamente, mas por um bom motivo: desenvolvimentos recentes levaram a resultados que antes não se pensava serem possíveis.

Deep Learning se baseia em algoritmos que analisam dados com uma estrutura lógica semelhante a que um ser humano usaria para tirar conclusões. Isso pode acontecer tanto por meio de aprendizado supervisionado quanto não supervisionado.

Para tanto, essa tecnologia usa uma estrutura em camadas de algoritmos chamada de rede neural artificial (ANN, do inglês Artificial Neural Network). O design da ANN é inspirado na rede neural biológica do cérebro humano, tornando o processo de aprendizado muito mais capaz do que os modelos-padrão de aprendizado de máquina.

As camadas intermediárias de algoritmos são chamadas de camadas ocultas, porque os seus valores não são observáveis no conjunto do treinamento. Em termos simples, é por meio delas que a rede faz a sua “mágica”. Quanto mais camadas ocultas o sistema possuir, mais profunda ele será. Em geral, qualquer ANN com duas ou mais camadas ocultas é chamada de rede neural profunda.

No geral, por meio da engenharia automática de recursos e de sua capacidade de autoaprendizagem, os algoritmos de Deep Learning precisam de pouca intervenção humana. Embora isso evidencie o enorme potencial do Deep Learning, só recentemente ele alcançou tamanha usabilidade. As duas principais razões são: a disponibilidade de dados e o poder de computação.

Em primeiro lugar, o Deep Learning requer quantidades incrivelmente vastas de dados. Em segundo lugar, esse modelo precisa de um poder de computação substancial. No entanto, com o surgimento da infraestrutura de computação em nuvem e das GPUs (unidades de processamento gráfico, usadas para cálculos mais rápidos, do inglês Graphic Processing Units) de alto desempenho, o tempo de treinamento de uma rede de Deep Learning pode ser reduzido de semanas para horas.

Mas, provavelmente, um dos avanços mais importantes no campo do Deep Learning é o surgimento do transfer learning, ou seja, o uso de modelos pré-treinados. O motivo: o aprendizado por transferência pode ser considerado uma cura para as necessidades de grandes conjuntos de dados de treinamento que eram necessários para que as redes produzissem resultados significativos.

Essas enormes necessidades de dados costumavam ser a razão pela qual os algoritmos de ANN não eram considerados a solução ideal para todos os problemas no passado. No entanto, para muitos aplicativos, essa necessidade de dados agora pode ser satisfeita usando modelos pré-treinados.

Resumindo:

- O Deep Learning é um subconjunto especializado de Machine Learning.

- Ele depende de uma estrutura em camadas de algoritmos chamada rede neural artificial.

- Possui grandes necessidades de dados, mas requer pouca intervenção humana para funcionar corretamente.

- O aprendizado por transferência é uma solução para as necessidades de grandes conjuntos de dados de treinamento.

Aplicações de Deep Learning

Hoje, o Deep Learning está presente em muitos campos. Nos veículos autônomos, por exemplo, ele é utilizado para detectar objetos, como sinais de PARE ou pedestres. Os militares usam essa tecnologia para identificar objetos de satélites, a fim de descobrir locais seguros ou inseguros para suas tropas.

Claro, a indústria de eletrônicos de consumo também está cheia de Deep Learning. Dispositivos de assistência domiciliar, como a Alexa, da Amazon, contam com algoritmos de Deep Learning para responder à sua voz e conhecer as suas preferências.

A Cellere utiliza essa técnica, por exemplo, para realizar a identificação de rostos em imagens diferentes, por meio da API Facematch, e para contextualizar documentos, com o Contextus. Ou, então, para a fiscalização inteligente de obras de infraestrutura ou outros serviços de campo, a partir da análise de fotos das atividades realizadas, permitindo a auditoria 100%.